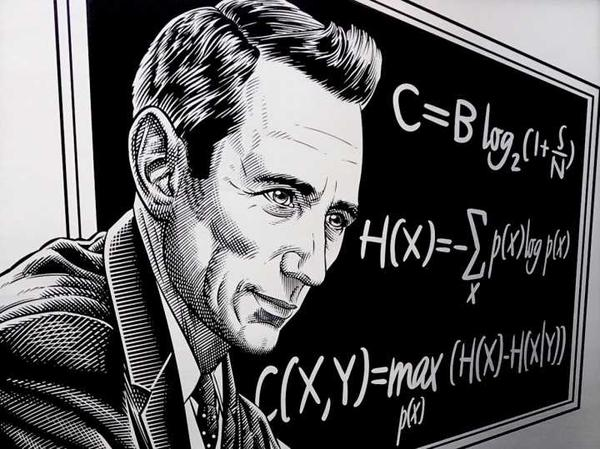

信息论基础

熵、相对熵与互信息 熵 定义:一个离散型随机变量 $X$ 的熵 $H(X)$ 定义为: $$ H(X)=-\sum_{x \in X}p(x) \log p(x) $$ 注释:$X$ 的熵又可以理解为随机变量 $\log \frac{1}{p(X)}$ 的期望值 引理 $H(X) \geq 0$ $H_b(X)=(\log_ba)H_a(X)$ 二元熵: $$ H(X)= -p\log p-(1-p)\log (1-p) \rightarrow H(p) $$ $H(p)$ 为上凸函数,在 $p= \frac{1}{2}$ 时取得最大值 1 ...